cPlay

Caratteristiche

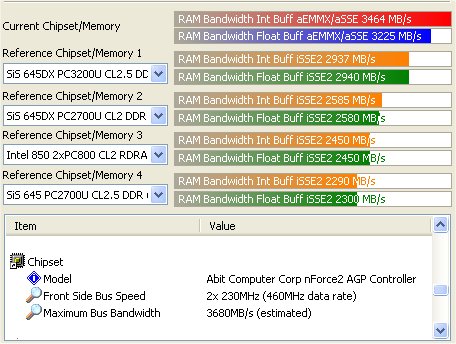

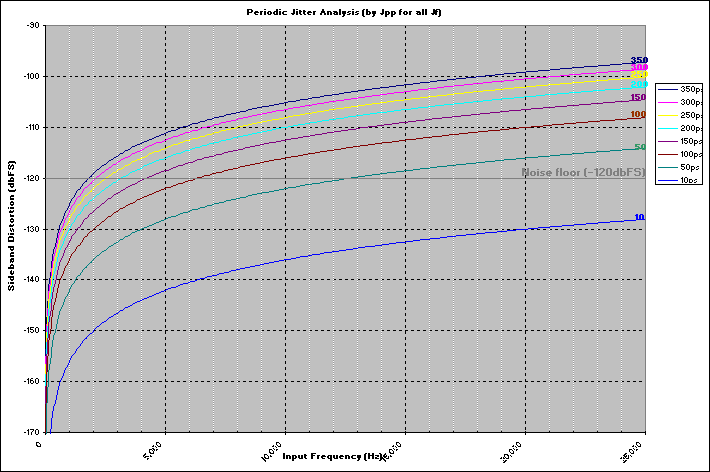

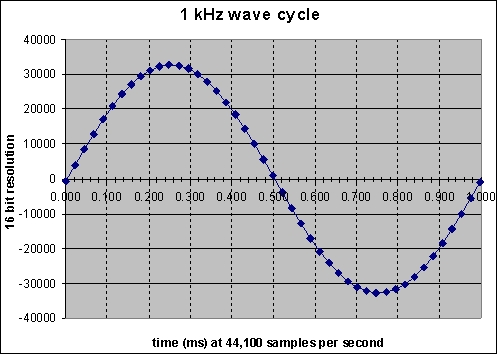

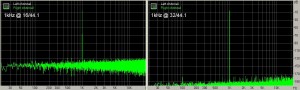

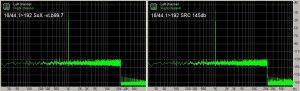

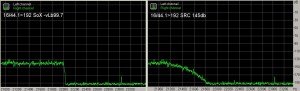

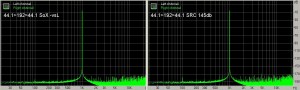

- Per il ricampionamento vengono utilizzati libsamplerate (versione 0.1.5) e SoX 14.2.0 sotto licenza GNU GPL. Libsamplerate è SRC (Secret Rabbit Code) e sostituisce la versione utilizzata da Foobar2000. Miglior convertitore Sinc ora offre un SNR di 145.68db o 121.33db (contro i 97dB). SoX VHQ offre un SNR migliore di 170db. Il ricampionamento viene bypassato quando la frequenza di ingresso corrisponde a quella di uscita.

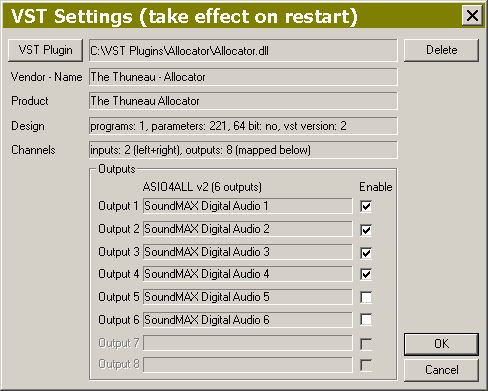

- Supporta l'eccellente Steinberg ASIO 2 ed è retrocompatibile con le versioni precedenti di ASIO (come richiesto dal driver ASIO stesso).

- Offre un controllo del volume digitale di alta qualità a precisione 64 bit (in incrementi da 0.5dB). Da cPlay 2.0b37 in poi, è disponibile il controllo del bilanciamento (in incrementi da 0.1dB) sempre a precisione 64 bit. Entrambi possono essere bypassati.

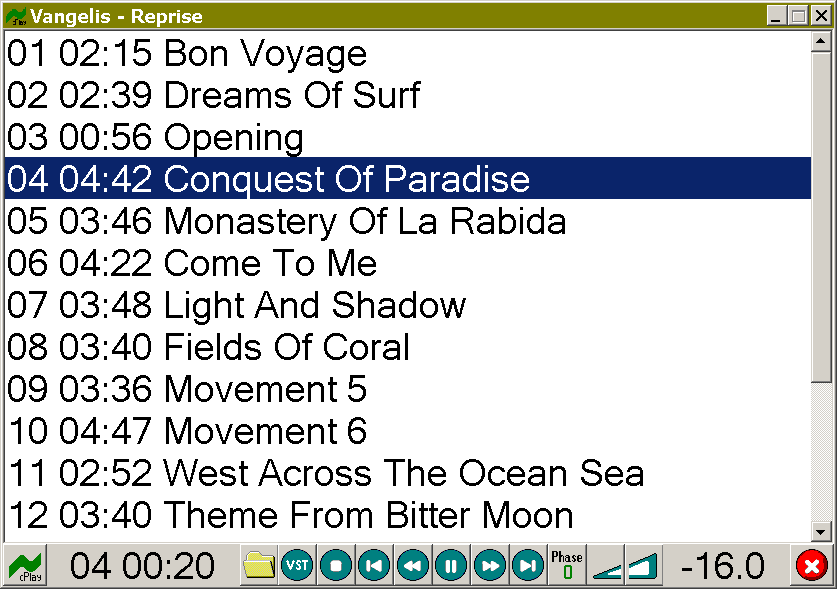

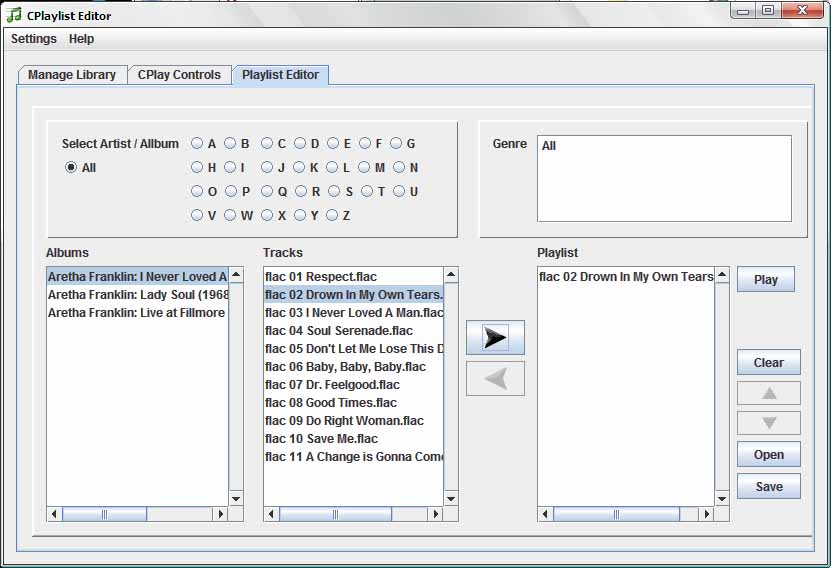

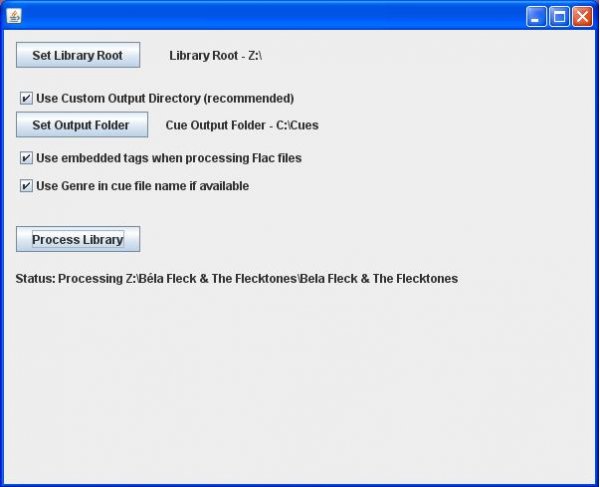

- La riproduzione avviene tramite file Cue (playlist), Wav o Flac. Prima di iniziare cPlay carica per intero il wav o flac (decodificato) nella RAM. La riproduzione è effettuata direttamente dal buffer interno di cPlay. La riproduzione tramite Cue richiede appunto file cue del tipo creato da EAC (standard singolo o multi file).

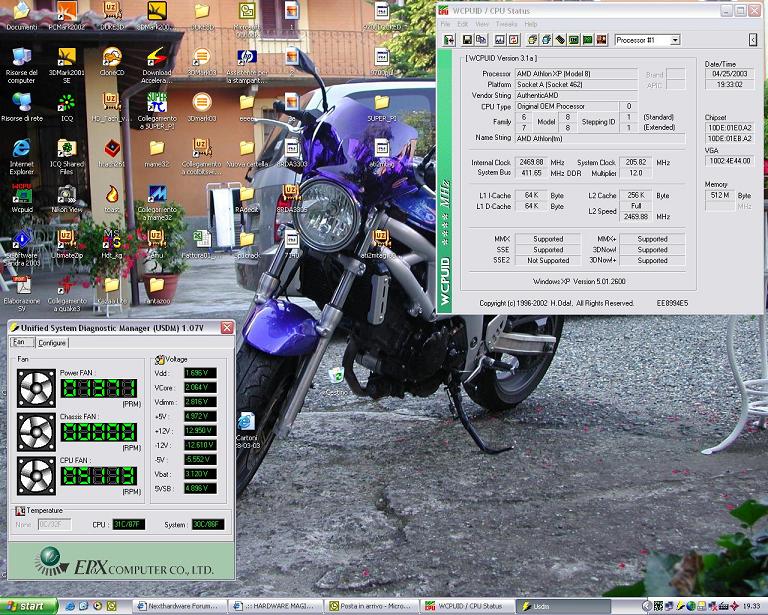

- Assicura un efficiente utilizzo delle risorse della CPU permettendo processori poco potenti o alti livelli di upsampling. Questo significa che la CPU può essere 'undercloccata/undervoltata'.

- Supporta fino a 3 schede audio ASIO con ciascuna fino a 100 canali in uscita.

- Se disponibile dal driver ASIO, sono applicate ottimizzazioni avanzate durante la riproduzione.

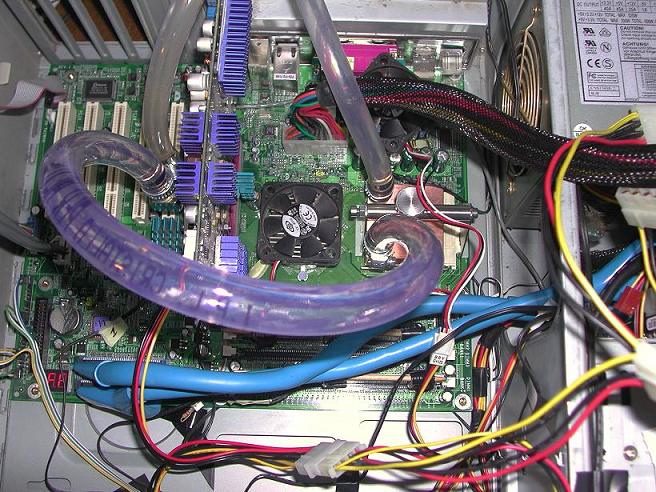

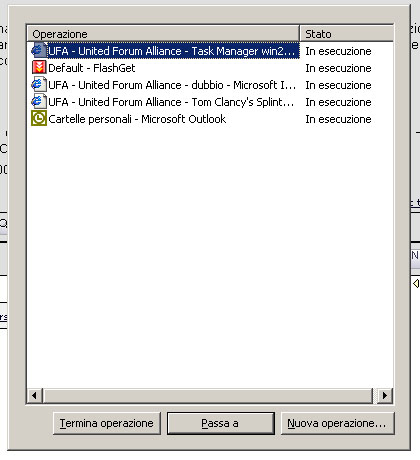

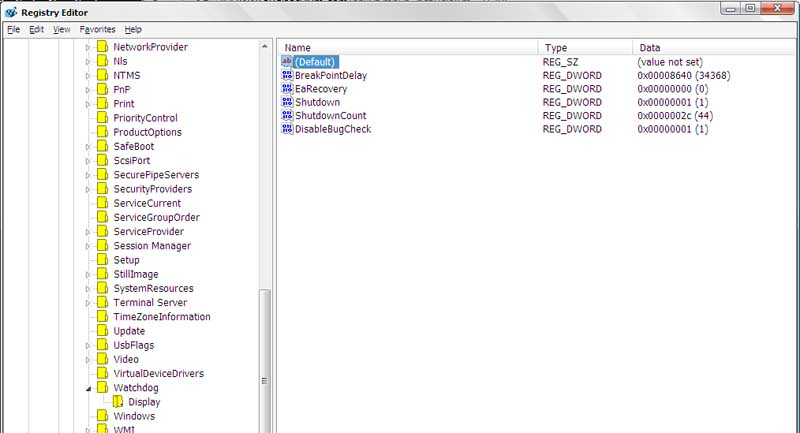

- Si ottengono i migliori risultati utilizzando cMP (cioè cMP²). Questo permette di ottimizzare a basso livello Windows. Usando la versione 1.0 o successiva di cMP, permette di evitare di caricare cMP in RAM (in cMP l'impostazione RAM Load è su No) altrimenti il file wav è caricato in RAM due volte. Inoltre, cPlay consente di sospendere sia svchost che lsass durante la riproduzione, riducendo ulteriormente il 'peso' di Windows. Unica eccezione è il driver ASIO della EMU, che richiede entrambi (svchost e lsass) per essere operativo. Impostare il settaggio 'Optimize' di cMP su 'Critical'.

- Il controllo remoto è realizzato da cMP tramite (wireless) mouse: a disposizione controllo del volume, navigazione per brano, successivo/precedente e stop/eject.

Specifiche

Media Format.........................Stereo only

WAV (16, 24, 32 PCM; 32 float)

FLAC (16, 24, 32 PCM)

DSP Design...........................128 bit processing

(SIMD & streaming used)

Multi-threaded

(event driven architecture)

Multi-core

(semaphores at hardware level)

Upsampler/Resampler..................Bandlimited Interpolation via

. "libsamplerate-0.1.5 (SRC)" [*1]

or (145db/121db SNR selectable)

. (154db/120db rejection)

........Multi-Stage Interpolation via

"SoX-14.2.0" (VHQ/HQ selectable)

(175db/125db rejection)

(clipping, if needed, done after

attenuation)

Attenuation..........................[-100.0,0.0] in 0.5db steps

(53 bit resolution)

Balance Control......................[-6.0,+6.0] in 0.1db steps

Left(-ve), Right(+ve)

(53 bit resolution)

Polarity.............................Phase 0/180 selectable "in flight"

VST Support..........................VST 2.4.2

Single low-latency plugin design

(2-in/max 8-out, 32 float, clipped)

Audio Output.........................32 bit

ASIO 2.2 (and backward compatible)

(KS, DS, WASAPI not supported)

Operating System.....................XP, Vista or Windows 7

(known to work on 64 bit systems)

Minimum Processor...................."Pentium 4" type (SSE2)

(core iX 32nm recommended)

Instruction Set......................SSE2 (SSE4 recommended)

Minimum available RAM required.......160MB

Maximum available RAM used...........1GB

Maximum tracks in cue sheet..........160 (including track splits)

Misurazioni